在这个“内容为王”的时代,网站建设公司推来客印象最深的就是原创文章对一个网站的重要性。如果一个网站在某个时间段,如果网页内容质量不够好,那么直接的结果就是网站降级,网站流量下降。

虽然我们知道原创文章的重要性,但大家也都知道,一两篇原创文章问题不大。网站文章的原创性是很难长期保持的,除非那些大站长的下属有一批专职的撰稿人或编辑。那么没有这样优厚条件的站长怎么办呢?只能是伪原创和抄袭。但是伪原创和抄袭的方法真的有用吗?今天推来客就来给大家分享一下搜索引擎判断重复内容的知识:问题一:搜索引擎如何判断重复内容?

1、一般的基本判断原则是逐页比对数字指纹。这种方法虽然可以找到一些重复的内容,但是缺点是需要消耗大量的资源,而且运行速度慢,效率低。

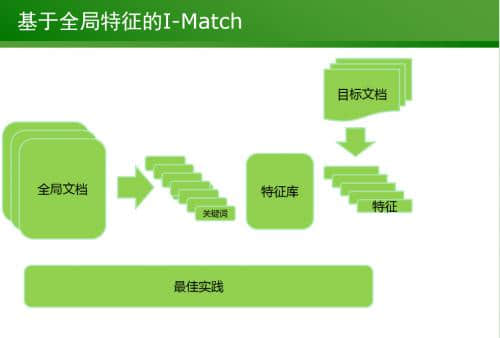

2. 基于全局特征的I-Match

该算法的原理是在打分前对文本中出现的所有词进行排序,目的是删除文本中不相关的关键词,保留重要的关键词。该方法去重效果高,效果明显。比如我们在伪原创,我们可能交换文章的词句。这种方法根本骗不了I-Match算法,依然会判断重复。

3. 基于停用词的Spotsig

如果文档中大量使用停用词,如语气助词、副词、介词、连词等,这些都会干扰有效信息。搜索引擎在去重处理时会删除这些停用词,然后进行文档匹配。因此,我们在做优化的时候,不妨降低停用词的出现频率,增加页面的关键词密度,这样更有利于搜索引擎的抓取。

4.基于多重Hash的Simhash

这个算法涉及到几何原理,解释起来比较困难。简单地说,相似的文本具有相似的哈希值。如果两个文本的simhash越接近,即汉明距离越小,则文本越相似。因此,海量文本查重任务转化为如何快速判断海量simhash中是否存在海明距离小的指纹。我们只需要知道,通过这种算法,搜索引擎可以在极短的时间内对大型网页进行近似的重复检查。目前,该算法在识别效果和查重效率上互为补充。问题二、搜索引擎为何要积极处理重复内容?

1. 节省抓取、索引和分析内容的空间和时间

一句话,搜索引擎的资源是有限的,但用户的需求是无限的。大量的重复内容消耗了搜索引擎的宝贵资源,所以从成本的角度来说,必须对重复内容进行处理。

2. 有助于避免重复收集重复内容

从识别采集的内容中归纳出最符合用户查询意图的信息,既可以提高效率,又可以避免重复采集重复的内容。

3、重复频率可以作为判断优秀内容的标准

既然搜索引擎可以识别重复的内容,当然可以更有效地识别出哪些内容是原创的,哪些是高质量的。重复频率越低,文章内容的原创质量就越高。

4.改善用户体验

其实这也是搜索引擎最重要的一点。只有把重复的内容处理好,把更多有用的信息呈现给用户,用户才会购买。问题三、搜索引擎眼中重复内容都有哪些表现形式?

1.形式和内容相似。这种情况在电子商务网站上比较常见,盗图现象比比皆是。

2.只是格式相似。

3.只是内容相似。

4.格式和内容部分相似。这种情况通常比较常见,尤其是企业类网站。

我们专注高端建站,小程序开发、软件系统定制开发、BUG修复、物联网开发、各类API接口对接开发等。十余年开发经验,每一个项目承诺做到满意为止,多一次对比,一定让您多一份收获!

更新时间:2024-09-28 03:23:53

更新时间:2024-09-28 03:23:53 网站建设

网站建设 641

641